AI 模型配置

开始配置

请求地址

不论是云服务商提供的模型,还是私有部署的模型,都需要提供 http 服务的地址, IP 或域名的都可以。

云服务商

云服务商提供的模型地址通常以 completions 结尾,例如:

- DeepSeek:

https://platform.deepseek.com/chat/completions - OpenAI:

https://api.openai.com/v1/chat/completions

微软 Azure 的模型取决与你自己的部署,参考该步骤获取请求地址

私有部署的模型

私有部署的模型地址则取决于具体实现,若通过 Ollama 在内网提供服务,则地址通常为 http://localhost:8000/api/generate。

密钥

云服务商提供的模型通常需要提供 API Key。

私有部署的模型则取决于具体实现,若通过 Ollama 在内网提供服务,则密钥可以为空。

注意

模型供应商的 API Key 需要用户自行申请,并妥善保管。

其他供应商

在页面中您还能看到我们对下列模型供应商做了支持,但我们目前无法保证这些模型的效果:

注意

大模型使用效果受模型供应商影响,HENGSHI SENSE 无法保证所有模型的效果。如果发现效果不佳,请及时联系 support@hengshi.com 或模型供应商。

OpenAI-API-Compatible

如果需要使用以上列表之外的模型,请选择 OpenAI-API-Compatible 选项,只要是兼容 OpenAI API 格式的模型都可以使用。

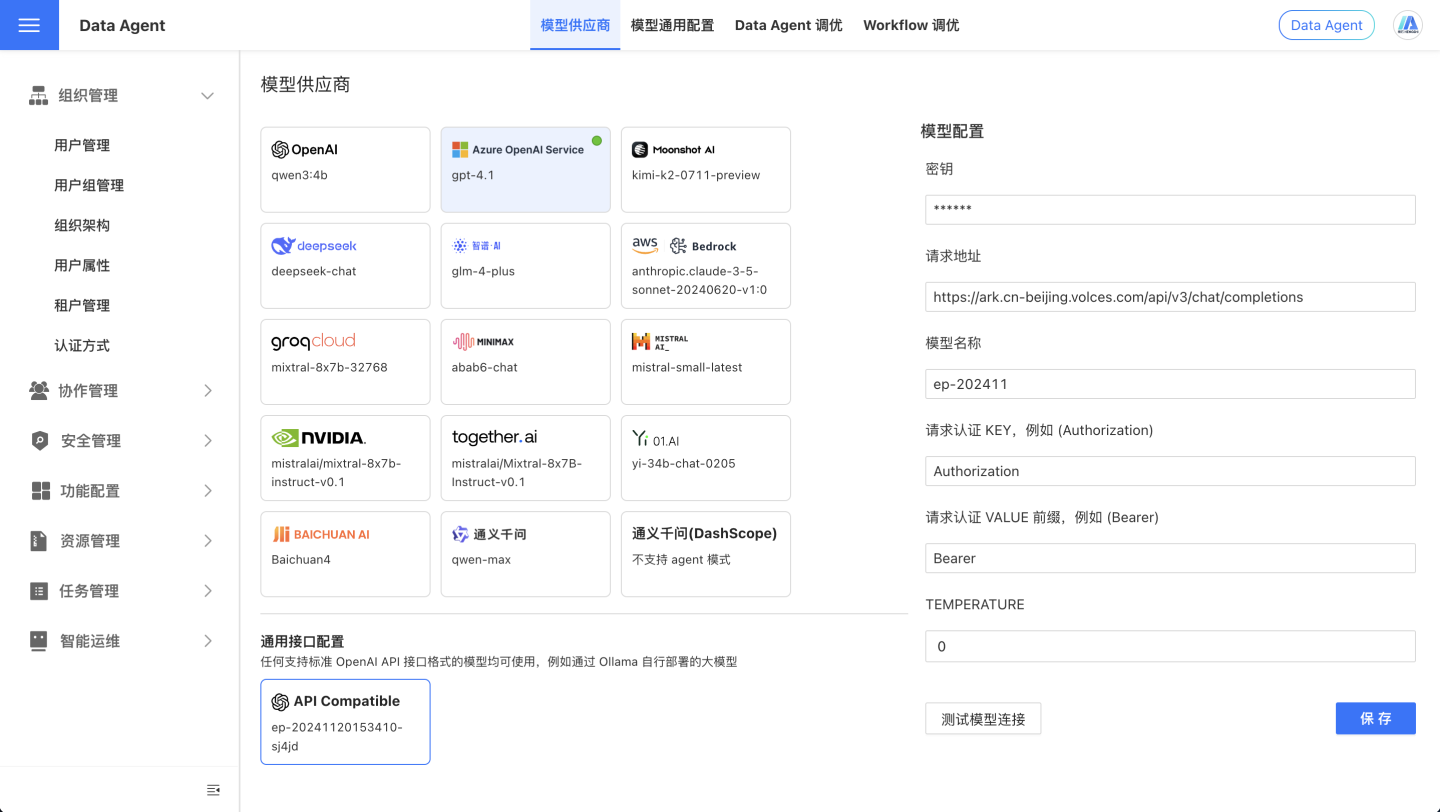

以 豆包 AI 为例,可以进行如下配置:

OpenAI API 格式

若你需要私有部署模型,请确保提供的 http 服务的请求地址和返回格式与 OpenAI API 保持一致,输入和输出的格式如下所示。

curl https://api.openai.com/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $OPENAI_API_KEY" \

-d '{

"model": "gpt-4o",

"messages": [

{

"role": "developer",

"content": "You are a helpful assistant."

},

{

"role": "user",

"content": "Hello!"

}

]

}'{

"id": "chatcmpl-123",

"object": "chat.completion",

"created": 1677652288,

"model": "gpt-4o-mini",

"system_fingerprint": "fp_44709d6fcb",

"choices": [{

"index": 0,

"message": {

"role": "assistant",

"content": "\n\nHello there, how may I assist you today?",

},

"logprobs": null,

"finish_reason": "stop"

}],

"usage": {

"prompt_tokens": 9,

"completion_tokens": 12,

"total_tokens": 21,

"completion_tokens_details": {

"reasoning_tokens": 0,

"accepted_prediction_tokens": 0,

"rejected_prediction_tokens": 0

}

}

}测试模型连接

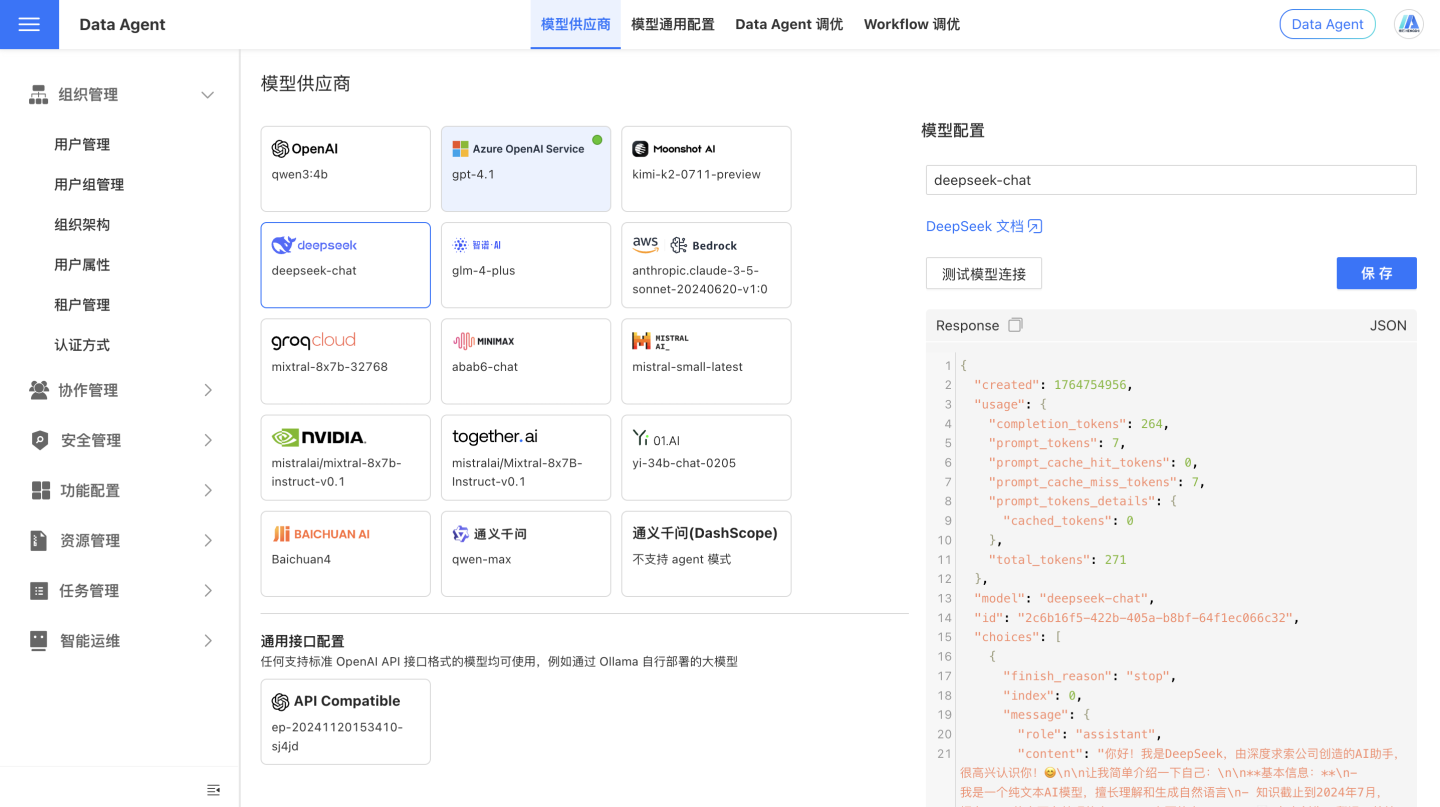

在配置好模型的 API Key 后,点击 测试模型连接 按钮,可以测试模型连接是否正常。如下图所示,如果连接正常,会显示出模型接口的返回内容。

响应速度

大模型的输出速度是硬件、模型复杂度、输入输出长度、优化技术和系统环境等多方面因素共同作用的结果。通常来讲,私有部署的小模型会比云服务供应商的模型响应速度慢、效果更差。

测试模型连接失败怎么排查?

连接失败有多种原因,建议按以下步骤进行排查:

检查请求地址

确保模型地址是正确的,不同厂商提供的模型地址是不同的,具体请查找你购买的厂商提供的文档。

我们可以提供初步排查指引:

- 各家模型提供商的模型地址通常都以

<host>/chat/completions结尾,而不是只有域名,例如https://api.openai.com/v1/chat/completions。 - 假如你的模型厂商是 Azure OpenAI,模型地址的构成是

https://<your-tenant>.openai.azure.com/openai/deployments/<your-model>/chat/completions,其中<your-tenant>是你的租户名,<your-model>是你的模型名,需要你登录到 Azure OpenAI 平台查看,更详细步骤请参考连接 Azure OpenAI。 - 假如你的模型厂商是通义千问,模型地址有两种,一种是兼容 OpenAI 格式的

https://dashscope.aliyuncs.com/compatible-mode/v1/chat/completions,另一种是通义千问特有的https://dashscope.aliyuncs.com/api/v1/services/aigc/text-generation/generation,当你使用 OpenAI 兼容格式(指 url 里包含 compatible-mode)时,请在衡石智能查数助手模型配置中选择OpenAI或OpenAI-API-compatible作为供应商。 - 假如你的模型是私有部署的,请确保模型地址是正确的,并且模型服务已经启动,确保模型提供了 HTTP 服务,并且接口的格式与 OpenAI API 接口兼容。

检查密钥

- 各家模型提供商的大模型接口通常需要密钥才能访问,请确保你提供的密钥是正确的,并且有访问该模型的权限。

- 假如你公司采用了自己部署的模型,密钥是有可能不需要的,请与你公司开发人员或你公司工程团队确认。

检查模型名称

- 各家模型提供商普遍都提供了多种模型,请根据需要选择合适的模型,并确保你提供的模型名称是正确的,并且有访问该模型的权限。

- 假如你公司采用了自己部署的模型,模型名称是有可能不需要的,请与你公司开发人员或你公司工程团队确认。